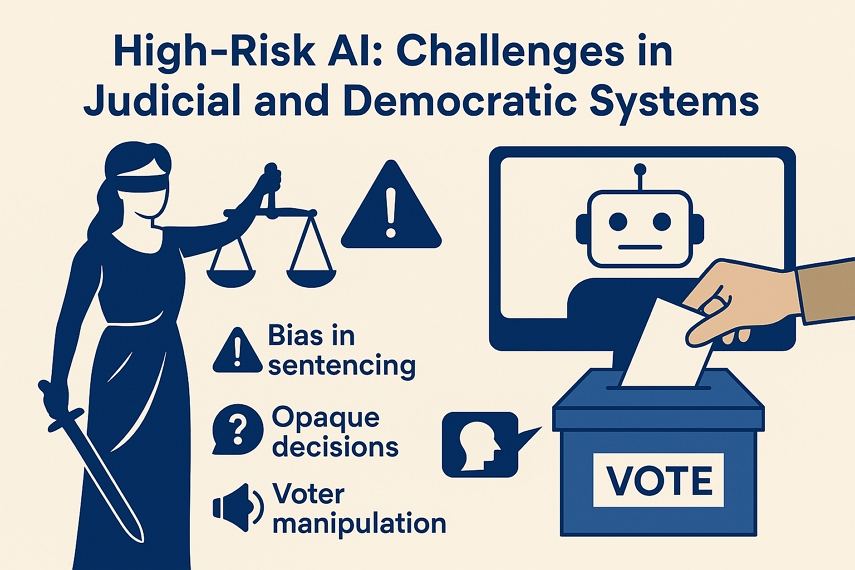

정의와 민주주의의 AI: EU AI 법에 따른 고위험 함정

AI 위험 평가 도구가 인종 편향으로 미국 피고인을 ‘고위험(high‑risk)’으로 잘못 분류하거나(ProPublica, 2016), 딥페이크 영상이 브라질 2022년 선거에 영향을 미쳤을 때, 사법 시스템 및 민주주의에서의 AI 위험성이 전 세계에 불거졌습니다. EU AI 법은 “사법 시스템에서의 AI”와 “민주주의에서의 AI”를 고위험(high‑risk)으로 분류함은, 이 영역에서의 오류가 기본권과 사회 신뢰를 위협하기 때문입니다.

이처럼 민감한 분야에서 AI의 힘을 활용하면서도 공정성, 투명성, 인권을 지키려면 어떻게 해야 할까요? 본 글에서는 이러한 고위험 AI 사용 사례, 중요한 위험 요소, 책임 있는 대응 전략을 다룹니다.

파트 1. 고위험 분야에서의 현재 AI 응용 사례

AI는 다양한 분야의 의사결정 시스템에 점점 통합되고 있습니다. 특히 “사법 시스템에서의 AI”와 “민주주의에서의 AI”는 속도와 효율성을 약속하지만, 대가도 따릅니다.

1. 사법 시스템에서의 AI

- 법률 문서 분석: 수천 건의 법률 문서를 처리해 사건 준비를 효율화함

- 예측 폴리싱: PredPol 등 알고리즘이 범죄 발생 가능 지역을 예측함

- 위험 평가 도구: COMPAS 알고리즘이 보석 및 형량 결정을 위해 재범 위험을 추정함

- 자동화된 증거 처리: 감시 영상이나 디지털 데이터에서 관련 증거를 자동으로 분류함

- 가상 심사위원: DoNotPay 같은 챗봇이 소소한 민사 및 항소 사건을 대화형으로 처리함

2. 민주주의 과정에서의 AI

- 유권자 행동 예측: 캠페인이 유권자 성향 및 의견을 추적함

- 타겟팅 정치 광고: 마이크로타게팅을 통해 개인 맞춤형 정치 메시지를 전달함

- 허위 정보 봇: 자동화된 AI 생성 콘텐츠로 허위 정보를 확산함

- 콘텐츠 중재: 플랫폼이 정치적 민감 발언을 자동으로 검열하거나 제거함

- 선거 예측: 예측 모델이 캠페인 전략 및 유권자 기대에 영향을 미침

파트 2. 고위험으로 분류된 이유: EU의 주요 우려 사항

EU AI 법이 이들 분야를 고위험으로 지정한 이유는, AI가 기본권을 침해하고 공공 신뢰를 저해하며 개인의 자유에 중대한 영향을 미칠 수 있기 때문입니다. 특히 사법 및 민주주의 영역에서는 위험 요소가 훨씬 큽니다.

1. 사법 시스템 관련 위험

- Bias 강화: 역사적 법률 데이터를 학습한 AI가 기존 불평등(예: 인종 재판 편향)을 악화시킬 수 있음

- 투명성 부족: 블랙박스 모델은 결과를 설명하거나 이의 제기할 수 없게 함

- 책임 공백: 오류 시 개발자, 기관, 알고리즘 중 누가 책임질지 불명확함

2. 민주주의 관련 위험

- 여론 조작: 딥페이크와 자동화된 선전이 담론을 왜곡할 수 있음

- 제도적 신뢰 붕괴: 허위 정보와 AI가 선거에 혼란을 주면 투명성 및 신뢰에 악영향

- 디지털 소외: 편향된 알고리즘이 특정 계층을 배제하거나 소수 의견을 억압할 수 있음

3. 교차 도메인 위험

- 데이터 오남용: 민감한 생체 인식 또는 행동 데이터가 동의 없이 사용될 수 있음

- 보안 위협: 공공 인프라에 적용된 AI가 사이버 공격에 취약할 수 있음

- 과도한 의존: AI에 과도하게 의존하면 인간의 판단력 및 감시 기능이 약화될 수 있음

파트 3. 사법 및 민주주의 분야에서의 핵심 AI 위험

AI의 효율성에는 대가가 따르며, 특히 사법과 민주주의 같은 분야에서는 공정성, 정의, 민주성이 걸려 있습니다.

1. 사법 시스템의 위험

- 형량 편향: 잘못된 학습 데이터로 AI가 체계적 차별을 악화시킬 수 있음

- 불투명한 의사결정: AI 기반 판결은 설명 가능성이 부족하여 법적 투명성을 저해함

- 인간 판단 약화: 판사와 변호사가 알고리즘 권고에 과도하게 의존하면 맥락적 판단이 감소함

2. 민주주의 시스템의 위험

- AI 생성 콘텐츠로 인한 조작: 가짜 영상과 조작된 이미지가 유권자를 오도할 수 있음

- 선거 신뢰 상실: AI의 역할이 은폐되면 결과 신뢰도 하락

- 마이크로타게팅으로 인한 분열: AI가 유권자 편향에 맞춘 콘텐츠를 제공하며 사회적 갈등을 심화시킬 수 있음

파트 4. 완화 전략: EU AI 법 준수를 위한 조치

EU AI 법은 고위험 AI 사용에 대한 일련의 안전장치를 의무화하고 있습니다. 준수는 법적 필수일 뿐만 아니라 도덕적 요구이기도 합니다.

1. 필수 안전장치

- 인간 감독: AI가 최종 결정을 내리기 전에 반드시 인간의 검증 필요함

- 편향 테스트 및 투명성 로그: 개발자는 모델을 감시하고 의사결정 로직을 공개해야 함

- 데이터 거버넌스: 모든 데이터 사용은 GDPR 기준과 윤리적 동의 절차에 따라야 함

2. 선제적 모범 사례

정부용:

- 독립적 알고리즘 감사: 제3자 평가로 중립성과 정확성 확보함

- 공공 AI 등록부: 시민이 어디에 어떤 고위험 시스템이 적용되는지 알 수 있도록 함

법조인용:

- 설명 가능한 AI 사용: 출력에 대한 명확하고 해석 가능한 근거를 제시해야 함

- 편향 지속 감시: 승인된 시스템도 회귀를 방지하도록 지속 감시해야 함

마무리

“사법 시스템에서의 AI”와 “민주주의에서의 AI”를 배치하려면 단순한 준수를 넘어선 윤리적 감시가 필요합니다. 도구는 인간의 판단을 “보완”해야 하며, 대체해서는 안 됩니다. EU AI 법 제1조의 선언처럼: “AI는 사람을 위해 봉사해야 하며, 그 반대는 안 됩니다.” 기관이 AI를 도입할 때는 투명성 감사(예: HitPaw VikPea의 편향 감지 기능 포함)와 다자 이해관계자 거버넌스를 우선해야 합니다. 그래야만 Loomis v. Wisconsin 사건과 같은 부당한 판결을 예방하고 민주주의를 알고리즘 조작으로부터 보호할 수 있습니다.

HitPaw Univd

HitPaw Univd  HitPaw VoicePea

HitPaw VoicePea  HitPaw FotorPea

HitPaw FotorPea

이 문서 공유하기:

제품 등급을 선택하세요:

김희준

편집장

프리랜서로 5년 이상 일해왔습니다. 새로운 것들과 최신 지식을 발견할 때마다 항상 감탄합니다. 인생은 무한하다고 생각하지만, 제 자신은 한계를 모릅니다.

모든 기사 보기댓글 남기기

HitPaw 기사에 대한 리뷰 작성하기